来源2022

提出问题:以往深度学习方法为了保证隐藏效果,大多为隐藏网络(H)和恢复网络(R)设计了复杂的网络架构,增加了模型部署的难度。

解决方法:探索了神经架构搜索的思想,实现一种更实用的隐写网络,有强大的隐写效果但是参数却要少得多(轻量级),本文的自动学习网络NAS-StegNet与最强大的模型相比参数少了26倍,所需要的GFLOPS也少了2倍。

深度隐写术概念:不是通过人工设计算法来找到合适的位置隐藏秘密信息,而是利用深度神经网络来更好的嵌入秘密信息。与传统(空域、频域)相比,隐藏能力大大提高:以图像隐写为例,深度隐写术可以将一幅或者多幅图像隐藏到另一幅大小相同的图像中,实现24bpp,远远超过传统方法的0.5bpp。

(CNN和GAN实际上是将深度图像隐写术表述为图像到图像的转换过程)

轻量级网络的必要性:尽管取得了 SOTA 成果,但现有的基于 U-Net 的隐写模型仍然难以部署,因为该模型非常复杂,共有 1660 万个参数,因此需要大量的参数存储空间。试想在这种情况下,当一个人需要向另一个人发送秘密信息时,他很可能是在外面行动或被人监视,因此很难使用大内存的电子设备。这时,小型嵌入式设备或手机就可以解决他的问题。然而,这些设备的内存较小,难以容纳大型机型。因此,研究轻量级的隐写模型非常重要。

寻找轻量级网络结构:最近,自动机器学习领域开始出现神经架构搜索(NAS)任务,用于解决大规模图像分类这一具有挑战性的任务。

本文贡献:(1)首次尝试将NAS应用于深度图像隐写术(2)实验结果表示与UDH不相上下,是迄今为止最轻量级的深度图像隐写术模型。

神经架构搜索(NAS)的解释:典型设计包含三个部分:搜索空间、搜索策略和性能估计。早期搜索策略主要包括强化学习和进化算法。最近的工作研究了 "一击"(one-shot)思想,这是一种两阶段算法。在第一阶段,训练一个超级网络,所有子网共享参数,最后将得分最高的子网确定为第二阶段的搜索网络。近年来,NAS主要利用图像分类任务来评估搜索结果的性能。Liu 等人将 NAS 引入语义分割领域,采用编码器-解码器结构,但主要搜索编码器,解码器直接采用固定双线性插值和 ASPP 方法。Weng 等人将 NAS 引入医学图像分割领域,并为上采样结构定义了一个特殊的搜索池。受这些语义分割工作的启发,本文沿用了可微分的 NAS 方案,以防止过多的资源消耗,并将其扩展到隐写任务中。

·本文方法:

1.隐写术任务的搜索空间:将单元定义为由N个节点组成的有向无环图,N个节点中的每个节点都代表一个中间节点,两个节点i、j之间的边代表搜索空间中的操作O。

如图,两个单元的输出被用作输入张量,从而得到输出张量。

红色箭头表示跨距为2的操作,绿色箭头表示跨距为1的操作,蓝色箭头表示连接操作。

最后,将中间节点的输出串联起来,作为单元格的输出。

将单元分为两种类型:下采样单元(DownCell)和上采样单元(UpCell)。下采样单元将特征图的高度和宽度减半。上采样单元与下采样单元相反。为减少参数和节省内存,保持DownCell和UpCell相同的通道数和初始数。

由于步长为 2 时编码器和解码器需要进行不同的操作,所以将 DownCell 和 UpCell 定义为下采样池(DownPo)和上采样池(UpPo),与 UpPo 相比,DownPo 池多了两个操作:最大池化和平均池化。在卷积操作方面,使用了深度可分离卷积(SepConv)和扩张卷积(DilConv)。下表所示为两个单元的搜索池中包含的操作:

2.关于网络结构设计解释:DARTS中使用的NAS是将整个网络预定义,然后只搜索单元块来形成最终网络,本文也采用这一做法,不是搜索整个网络,而是对现有的基本网络稍作改动。UDH包含两个网络H 与R,本文沿用这一结构,简单的将R网络设置为多个Conv-BnRelu 块的叠加,只搜索H网络的结构。

与图像分类是获取高级语义结果的图像分类任务不同,隐写术任务需要获取像素级(低级语义)的结果。因此本文采用编码器-解码器结构U-Net为主干以减少内存,为适应任务,做出一定修改:将 DownCell 的输入定义为最后两个单元的输出,而对于 UpCell,则定义为前一个单元的输出和具有相同分辨率的 DownCell 输出:

3.关于搜索策略的解释:

损失设计:

··实验部分:

数据集:CIFAR10和 ImageNet-1K是广泛用于 NAS 研究的数据集。使用了CIFAR10低分辨率的数据集上进行搜索,以减少搜索最佳结构所需的 GPU 天数。还使用了ImageNet-1K 的90,000 张图像进行训练。

评价指标:峰值信噪比(PSNR)、结构相似度(SSIM)和感知相似度(LPIPS)、平均像素差异(APD)

实验结果:下图表示在CIFAR10 上找到的最佳架构。

下表显示了评估结果,可以看到参数从16.65M减少到0.69M.

消融实验:评估SepConv 对 U-Net 的影响。在实验中简单地将 U-Net 中的原始卷积层转换为 SepConv,发现SepConv 虽然可以减少网络参数,但也会使网络丢失部分信息,导致秘密信息提取效果变差。这说明本文寻找的网络结构更适合隐写任务。

网络深度 l(单元数)和网络宽度 ch(通道数)对模型的影响:结果表明,当 l =8 和 ch = 64 时,可以获得更优越的性能。此外,当 l = 4 时,可以进一步减少参数,同时略微降低 PSNR 值。此外,当 ch 值设置为 16 时,性能会急剧下降。

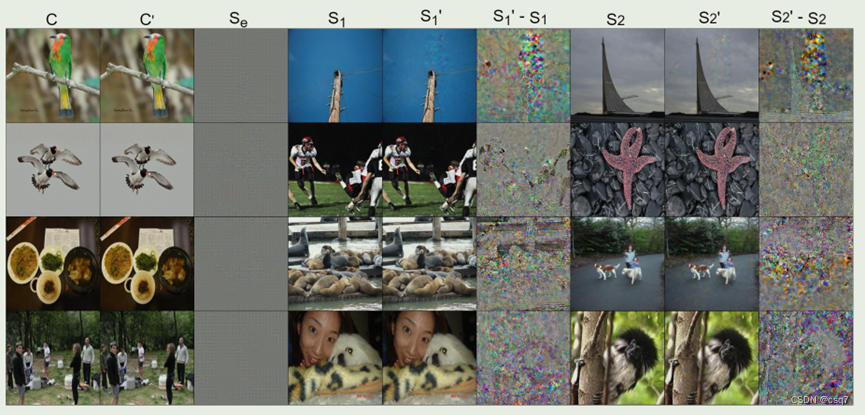

多图像隐藏:

两张图像,视觉效果达标,可见其确实轻量化。

总结:

(1)通过使用 U-Net 作为基本结构并执行单元级搜索,搜索出了一种新型 NAS-StegaNet,并证明其结果接近甚至优于功能强大的 UDH,但参数却少得多,仅为 UDH 的 4%。

(2)目前,揭示网络没有与隐藏网络一起搜索,这可能会造成网络不一致,导致模型性能下降,模型的安全性也没有得到验证。我们建议针对这两个薄弱环节开展进一步研究。

原文链接:https://blog.csdn.net/qq_44654715/article/details/136554532?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522bcdffe4c3e164d58b445b95efacaac28%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=bcdffe4c3e164d58b445b95efacaac28&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-7-136554532-null-null.nonecase&utm_term=%E6%9E%81%E7%A9%BA%E9%97%B4nas