什么是搜索引擎

搜索引擎是一个帮助用户搜索他们需要内容的计算机程序。换一种说法,搜索引擎把计算机中存储的信息与用户的信息需求(information need)相匹配,并把匹配的结果展示出来。

搞懂了搜索引擎的工作原理之后,可以解决优化当中很多问题,如网站网站蜘蛛有没有来网站,网站为什么没有收录,网站为什么有收录,没有排名。

搜索引擎为想要抓取互联网站的页面,不可能手动去完成,那么百度、google他们的工程师就编写了一个程序,他们给这个自动抓取的程序起了一个名字,爬虫(也可以叫做“蜘蛛”)。

互联网上的信息存储在无数个服务器上,任何搜索引擎要想回答用户的搜索,首先要把网页存在自己本地的服务器上,这靠的就是网络爬虫。它不停的向各种网站发送请求,将所得到的网页存储起来。那么它怎么知道往哪发送请求呢?通常的做法是利用网页之间的链接从一个网页出发,提取出指向其他页面的链接,把它们当成将下次要请求的对象,不停重复这个过程。有很多细节要被考虑。比如避免循环链接的网页;解析网页文档(通常是html格式,但也有很多其他格式)提取里边的链接;当链接无法打开时对错误进行处理等。

出于安全等因素考虑,很多网络服务器都有反恶意爬虫的功能。尽管他们所采取策略各不相同,共a同点是他们目标就是尽量只响应用户的请求。但搜索引擎爬虫通常不需要担心这一点,因为大部分网站都希望提高自己的搜索排名,欢迎搜索引擎爬虫到访。

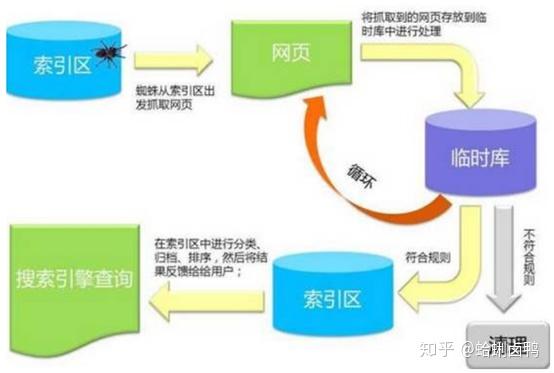

搜索引擎的工作分为4个步骤:

1、 爬行

形象的理解起来像网上正在爬行的蜘蛛,通过特定规律的代码,对网页的链接进行跟踪,如此依次进行,从一个链接爬到另外一个链接,因为是机器执行,也被称作为“机器人”。

从海量信息中,按一定的规则.收集网站内容,最终提交,并将结果反馈给抓取程序。可理解为信息收集人员。

2、 抓取

以改善用户的搜索体验为目的抓取程序,则是将“爬虫”所收到的信息进行初步的检测与分类,把其中有效的信息用户关注强烈的信息.合法的信息稀缺信息等获得,并存放到数据库容器里面通过下一部的收录程序进行进一步的严格审核。可以理解,它是信息采购人员,对信息人员的收集来的信息进行初步的筛选。

3、 收录

一系列作为收录的规则将通过第1、2步的信息进行对比,并逐条判断.将符合规则的内容,放到专用来存放索引数据库,从而建立起索引,这样很大的提高了用户的搜索效率,这样,一个页面内容也就在索引数据库中收录成功了。

4、 排名

排名的计算方式是:对搜索词处理,对照数据库匹配,初始数据选择,相关性计算,过滤调整到最后的排名。根据用户的搜索关键词进行排名的一个规则机制,如何在海量的索引库中,取得好的优先排名,也就成为SEO所要研究的主要方向。随着搜索引擎的发展和进化.越来越智能,规则算法越来越复杂。

整体说来,搜索引擎的核心就是满足用户需求,把用户需要的知识呈现在用户面前,一切从满足用户需求出发。

关于网络爬虫,在下面这篇文章有作介绍:

原文链接:https://zhuanlan.zhihu.com/p/242311093